A NVIDIA divulgou novos benchmarks da GPU de inteligência artificial H100, colocando ela lado-a-lado da MI300X da AMD. A intenção era mostrar como a sua placa de vídeo continuava na frente, mesmo um ano após seu lançamento, revelando que ela é 47% mais veloz do que o hardware produzido pela rival.

De acordo com a fabricante, este avanço se deve aos diversos aprimoramentos que aplicaram em seu software. Um dos mais recentes são as melhorias no TensorRT-LLM que é focado em workloads de IAs com otimizações de nível-Kernel.

A resposta surgiu depois de uma demonstração da AMD sobre o MI300X, qual usaram o Llama 2 70B para mostrar uma velocidade maior em servidores 8v8 (40%) e em comparação 1v1 (20%). No entanto, enquanto eles rodavam a GPU deles com todas as atualizações no software, a Hopper H100 estava “crua”.

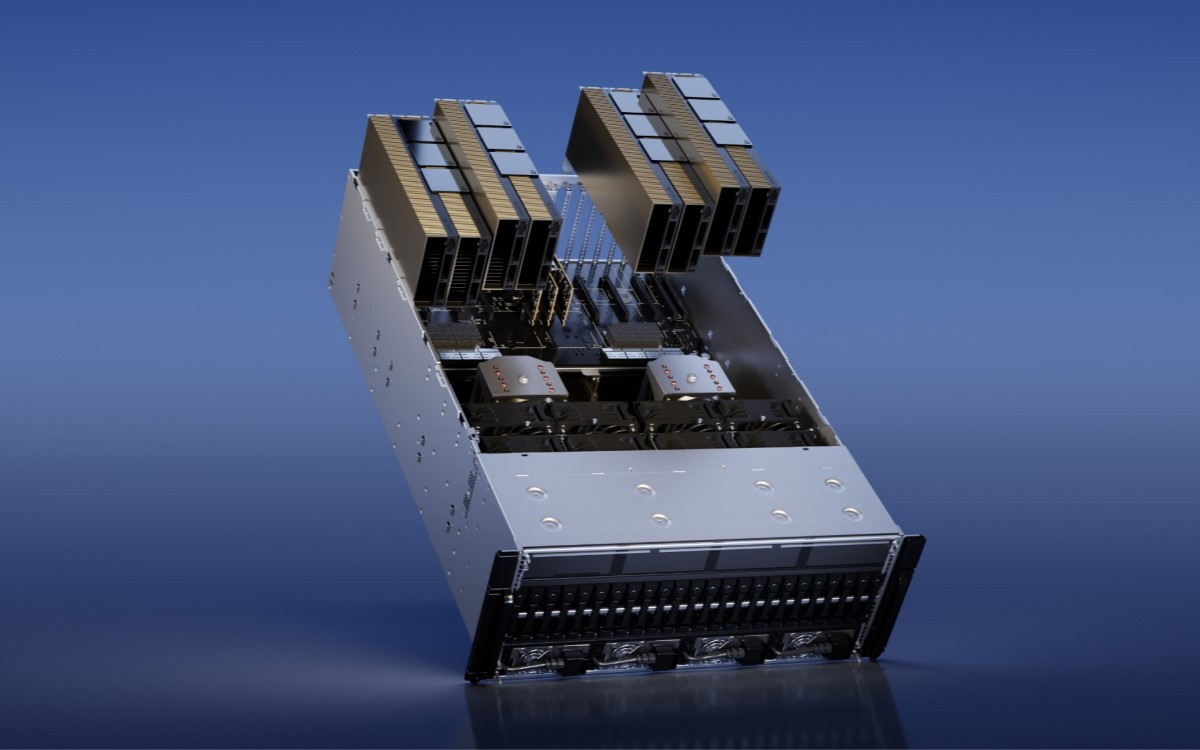

A NVIDIA rebateu e decidiu revelar seus próprios benchmarks, desta vez com a última versão de seus softwares e mostrando os resultados reais para a indústria. Segundo os dados apresentados, os workflows da DGX “Hopper” H100 são duas vezes mais velozes em servidores e na solução de 8 GPUs mostra uma velocidade 47% maior.

Nos resultados abaixo, você pode conferir os dados apresentados pela AMD durante o “Advancing AI” e como ela realmente se comporta nas mesmas configurações – porém, com o software atualizado.

A análise da NVIDIA

A NVIDIA também revela mais informações sobre a sua avaliação de desempenho. “A DGX H100 pode processar uma única inferência em 1,7 segundos usando o tamanho de um espaço. Em outras palavras, ela faz uma solicitação de inferência de cada vez”.

Eles falam sobre como essa velocidade é aplicada. “O tamanho de um espaço com um tempo de resposta veloz traz grandes diferenças no modelo de IA. Para otimizar esta velocidade e o rendimento do servidor, os serviços em nuvem definem um tempo de resposta fixo para serviços específicos”.

No fim, a NVIDIA também revela como isto ajuda. “Isso garante a combinação de múltiplas solicitações de inferência em ‘espaços’ maiores, aumentando as inferências gerais por segundo nos data centers. Benchmarks como o MLPerf também medem o desempenho com essa métrica de tempo de resposta fixo”.

Eles também se comparam ao rival. “Pequenas trocas no tempo de resposta podem desencadear inúmeros fatores nas solicitações de número de inferência que um servidor pode processar em tempo real. Usando um tempo de resposta fixo de 2,5 segundos, um esquema de servidor com 8 GPUs DGX H100 pode processar até cinco inferências por segundo no Llama 2 70B em comparação a menos de uma com o modelo citado”.

Fonte: WCCFTECH

Participe do grupo de ofertas do Adrenaline

Confira as principais ofertas de hardware, componentes e outros eletrônicos que encontramos pela internet. Placa de vídeo, placa-mãe, memória RAM e tudo que você precisa para montar o seu PC. Ao participar do nosso grupo, você recebe promoções diariamente e tem acesso antecipado a cupons de desconto.

Entre no grupo e aproveite as promoções